2017 台灣人工智慧年會 Day 1 筆記

目錄

2017年秋天參加了台灣人工智慧年會,把筆記記錄在這裡。當天的 議程表連結也留著。

[KeyNote] Taiwan’s Opportunities in the AI-First World #

簡立峰 #

Artificial intelligence 是從 web→mobile→cloud 的成果,不是單一存在的。台灣必須要跨領域才能扭轉。現在這個時間把焦點放在全球化和台灣在世界的定位,而不是只是追逐現有的單一技術。 AI 應用現在最好的應用點: 有大量影像的東西 自駕車出現後你會出現新的需求 → Motel? 保險? / 直播? 旅行?

台灣在open-source是在科技國家中表現最差的: 源自於我們來自於代工業,我們不會在馬路上找客戶,會跑去展場;科技型的計畫一直在浪費,一直再建平台。看 snapchat 的運作,我們要學會用工具,例如prototyping tool (註: grow fast fail fast)。正確的應用服務: rapid prototyping → user 買單 → 開發,正確的應用研究: 縮短測試期,最快速接觸到user 再回來 真正的贏家不是做工具的人,而是從使用者端

投資AI是大趨勢,你要發揮你的優勢。想知道AI的發展 → Check Wiki。

AI風暴來自延續的科技發展,台灣在2000年後因為網路泡泡停止對網路投資,我們錯失了大量的機會。但是,這些年來我們在半導體產業默默的創新,有鑑於我們是一個B2B的島國,台灣缺乏橫向連結,都在做代工。2007年我們又錯失了開發APP的起飛,其實Web產業當下已經結束了。全世界per user花在手機時間裏頭台灣可能是世界第一,我們太喜歡我們看到的東西了。(game, playstore, 不重視,社會觀感)

“Software is Eating the World”

為什麼我們沒有感覺? 因為我們我們沒有scale。手機重要嗎? 世界上有400 萬App→ 每個人平均用8個。他是一個封閉的ecosystem,很難獨力創造機會。Web是相對開放的。 世界趨勢: Brand is declining 所以連帶的台灣代工decline。新經濟的崛起是存生產走向服務,這也是為什麼巨型科技公司都是服務導向的公司。更重要的是網路服務造成全世界的消費者已經趨近相同,看看在地化的yahoo首頁走向google的單一性入口。

2010-2017 上網人口增加一倍。不是來自中國了,也不會。

過去40年,機會都在台灣附近。試試看換個角度看台灣

趨勢: Smartphone as AI Supercomputer (Trend: Hardware for AI),各人資料將放回到手機端。AI @ Home,有關人的生活資訊開始被挖掘和儲存。Drone & Car。

台灣的我們沒有應用的習慣,因為我們只擔心撞到101。

台灣的機會在哪裡 AI 硬體有優勢,AI應用要把握。 把軟體的人才放進不同的產業,用硬體跨領域。把它放進醫療、放進傳產。 我們要讓自己更有信心。我們把自己想的太大就變得太小。你在風暴裡頭你有很多優勢。

台灣家裡如果有兩個小孩: 如果你走出去,你會看到機會 https://www.inside.com.tw/2017/09/27/ai-industry 離中心近 - 要 open-minded 把服務差異化找出來,台灣人的信賴最高。Accessibility and trust society,可以從醫療/食品/心理諮商下手

對了,如果你只有一個小孩,就只好讓他飛來飛去。

(本場結束,整理完畢)

[R0] 紀懷新 - Optimizing for User Experience with Machine Learning #

Google Research & Machine Intelligence Principle Scientist 首席科學家

Nothing tends so much to the advancement of knowledge as the application of a new instrument

- Humphry Davy

怎麼用工具去提升使用者體驗? 要問的問題是: 人與機器的互動應該長什麼樣子? What are Happy Engaged User? Embrace AI + ML to improve User Experience: Measure → Optimize → Impact

» Interlingual Social Interaction 從社群媒體來討論。它存在的目的是為了 Reduce Isolation。我們可以從graph in-degree 去看大家都follow什麼人。

Facebook: bi-directional (必須互訪) G+, Twitter: uni-directional (不須互訪) Cutoff 來於好友限制

也可以觀察graph 中的Clustering Coefficient: More connection → more dense

很多在做measurement in HCI research,但也別忘記去找result 的solution。 在做 G+的時候,我們看到的Challenge就是要怎麼樣Connect more people? 當初我們想做的第一件事就是做出 translate。才剛開始我就後悔了。

- 什麼是什麼語言? 中英混雜? 如果有個post 他寫了 “Hello” 這到底是什麼語言?

Beyond its there.

而做出來的結果也非常有趣

轉發轉發和分享增加了,但是因為你開始看懂別人罵你的東西,所以mute item 也增加了

» Sequential Recommendation The recommendation Problem: 必須要先理解 User, Context 和 Item + Low Latency 所以我們開發了 RNN 做 Recommendation。以前我們都用correlation在理解,但是 Casualty 理解的是時間序位上的前因後過。Time Based Sequencial RNN,重點是 Time-Based.

» Focused Learning 用電影當作例子,傳統上我們會用Loss Function 去做處理推薦系統,但是會遇到的問題就是每個類別,每部電影的loss其實很不平均。 Approach: 所以我們必須要取用 focused data 去做 training 和 validation + 把 unfocused data 放進去去排除 sparse data 的bias. 請看數學公式。

回到用戶體驗的角度 要先知道 → What you are optimizing for? 你優化的東西要是有用的 然後因為真實世界很亂,所以他很難,因為很難,所以可以善用像ML+AI這樣的好工具。

問: 我沒有Domain knowledge 怎麼知道我要去 Optimize 什麼? 答: Intuition 往往是錯誤的,雖然Measurement 很難。

(本場結束,整理完畢)

[R0]邱中鎮 - Recent advances of deep learning in Google #

Google Brain Software Engineer

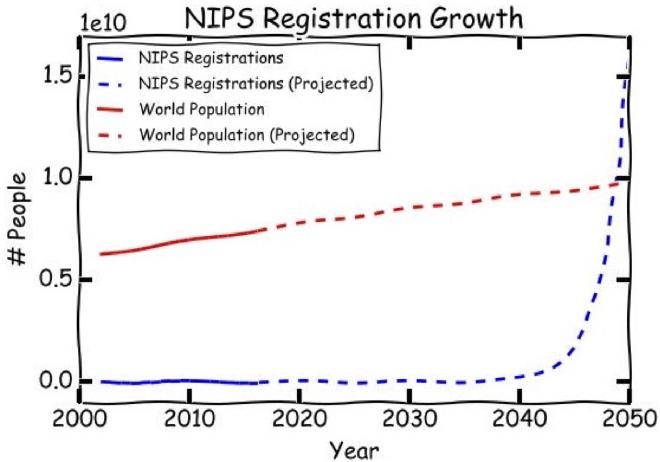

(註:我不是NN專家,這場演講只有bullet point) NN 很紅,所以今年很難買Coference 的票。

淺談Neural Network 的歷史 (略)

在 16’ResNet的研究發現,Layer越多並不代表越精準。所以近幾年來其實重大的突破專注在改變Architecture. 這也是為什麼我們專注在做用 Neural Network 調整 Neural Network (Learning to Learn). Zoph & Le’17 在 Learning to Learn 導入了 自然語言 + LSTM來做訓練。Accuracy 完全超越人類專家。

Google NN Translation 使用 Sequence-to-Sequence with attention. 在 Encoder 和 Decoder 之間加入了attention. Attention Is All You Need ****這篇paper (…好我沒聽懂)

逐漸的Google 把NN的成果轉移到醫學的影像辨識。我們正在tackle 的問題如下:

在Robotics 的NN 中,我們一個很大的突破是用demonstration或simulation去教機器手臂,例如說把多視角去拍攝某個動作,在把動作map給機器手臂。(這好酷!)

\TensorFlow/ \TensorFlow/ \TensorFlow/ (原來這場是為了這個艮…..) \TPU/ \TPU/ \TPU/ (我就知道)

(本場結束,整理完畢)

[ 去吃晚餐囉~~~ 下午resume]

(開始囉~)

[KeyNote] 張智威 - Representation Learning on Big and Small Data #

HTC Research & Healthcare President

我們要切入新領域之前一定要先理解技術來源。

機器學習處理big data 必須要用 low complexity algorithm 才能快速反應使用者 然後才去improve precision。當初在Google 發現的問題是,當research paper 說better algorithm on 百萬等級的data set 時,放到billion 的data set 並沒有out perform 最簡單的結果。這時一個 big data vs. better algorithm 的區別。

那我們來看ML到頭來就是在做 classification. classification 基本上就是nearest-neighbor search。面對curse of dimensionality 的問題下,big data 變成是必須的,要塞滿那些sparse dimension.

\DeepQ/ \DeepQ/ \DeepQ/ (我就知道)

現在的醫療還是一個 Reactive mode 被動的,而且非常沒有效率 → 需要典範轉移。 所以應該要提倡: IOT + Cloud + AI (proactive + prevention) → Distributed Healthcare HTC healthcare 希望可以做出一個可以偵測疾病的工具。例如: Symptom probing (透過reinforcement learning) 來做診斷和協助先行檢測。 在Healthcare 中必須要點出的他與一般ML (Alpha Go) 的不同,所以我們提出一個agent-for-part 的架構。(aka distributed human body)

另外一個我們來講中耳炎的例子。因為有限的data (~1000),我們用用無關的data把NN的low level 先建立起來做成codebook,才跑中耳炎的image,我們發現他的精確度可以高達90%,當我們回頭看到底他呼應的無關的image是那些,才發現某種程度她就在做比喻。

醫學很大的問題是太少data。

謝謝 Google看不起我們 (好嗆 QQ) 現在 HTC 希望可以變成 Healthcare Data Platform,請大家加入我們,拜託。

(本場結束,整理完畢)

[A1] 宋政隆 - 深度學習環境建置與模型訓練實務 #

HTC Research & Healthcare Senior Manager

沒有科技是解藥,需要基礎慢慢做,我說Deep Learning. \DeepQ/\DeepQ/\DeepQ/

我覺得Google 也還不錯啦,平衡一下剛剛老闆講的…

我專注的問題是,我要怎麼用cloud computing 做 deep learning? 不然日子就這樣過去了。

我們的平台很好,那我們等等來demo. (其實真的還不錯的感覺)

有時候選擇很簡單,只是你會不會而已(笑)

所以AWS Azure 和 GCP 要選哪一個呢(我們是照字母排!)

(演講結束,大概整理了)

[R2] 黃維中 - 預測式分析於商務服務之應用與挑戰 #

工研院巨資中心 / 副主任

» 消費偏好預測 最早是 item-to-item for user-item matrix,透過矩正降維 (matrix-factorization) 來處理。

» 原物料價格預測 (類似期貨) 需考量上下游以及外部便因放入討論。使用的模型有傳統的time series analysis: ARIMA (autoregressive + moving average to adapt time series analysis) 、GARCH、NGARCH等。Neural Network 基本上可以使用在Quantitative finance 之中。可以再透過自然語言分析去把外部人為因素拉進來跑ML。到底要怎麼把外部的資料加入NN來處理呢? (Human are not rational) 現階段的成果是透過網路上的關鍵字 + NLP 去處理他的喜好度,然後用 RNN 推測商品價格銷量的轉折點。

» 金融理財 為了投資而非投機面相處理。 KYC → Quantitative + ML → 資產配置+屬性分類

挑戰與心得: 資料來源的缺乏

[R2] 李祈均 - 機器智能與人類行為: 跨領域決策分析於醫療應用 #

清華大學電機工程系 助理教授

預測2021年醫療科技的應用可以達到10x。 我們從人的行為是高維度的,所以再研究狀態的時候是高度非線性相關的。

» 預測 所以我們要做的第一件事情就是處理高維度資料輔助專家的診斷。 人的習慣(專家)就是把高維度的東西做各種向量的投影,透過這些經驗去做診斷,所以我們要問的事情是可不可以用機器來幫我們處理高維度的資訊。

流式細胞儀透過ML可以達到90%的準確率把20分鐘的task變成7秒。 » 行為 我們可以從健保資料庫去看 “醫病行為” 的分析? 假設我們拿中風的資料: 把舊整紀錄資料和個人資料做出中風預測。跑DNN囉~

DNN幫助我們去看高維度的資料

結果的精確度可以達到92%

» 量化感受 另一個例子是非結構式行為紀錄用於醫療: moment to moment ,這個領域我們稱作是 Behavioral signal processing (BSP) 我們就來看台灣的急診檢傷分級 (physical + 疼痛程度),後者在臨床上是有困難的(現在是用問的),所以我們可不可以量化這樣的資訊。 所以我們就用語音訊息 + 臉部計算來跑機器學期。(其實某種程度上這是在做資料collection ?) 在兩種分級上可以到達80%的正確率,最有趣的還是在聲音的準確度 > 臉部辨識。

最後一個例子是自閉症 (increase rate exponentially) 人去做: 寫下一個診斷和觀察 (high dimensional 投影在文字上面) 我們從 Lexical Coherence 去觀察自閉症小孩在看圖說故事的狀態。那我們能不能規模性的去計算他?

computational linguistics vs LSTM+LC: 73% vs 92% data-driven 可以更巨量的做分析

» 結論 規模化+一致化的去計算人類的行為和感受,不需要再完全依賴 “感覺”。 顯微鏡不只是放大,是找出新的可能性。 (直播結束,整理完畢) (本日議程結束)